在 Meta Connect 2024 活动上,Mark Zuckerberg 宣布了全新的 Llama 3.2 模型系列,在开源模型中首次引入了对多模态图像的支持。

Llama 3.2:针对设备本地任务优化

Llama 3.2 系列包含了两个较小的模型——Llama 3.2 1B 和 3B,它们经过深度优化,专为本地和边缘设备任务而设计,能够在移动设备和笔记本电脑上高效运行。

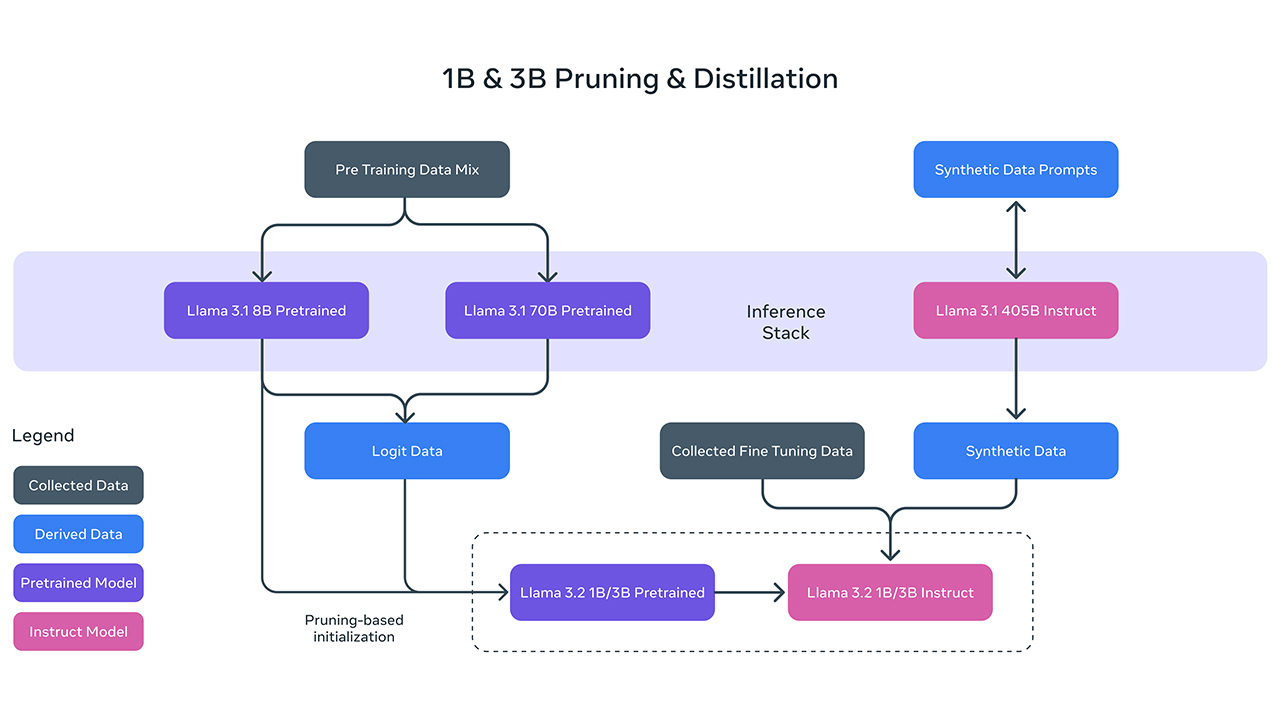

Llama 3.2 1B 和 3B 是通过对 Llama 3.1 8B 和 70B 模型进行剪枝和蒸馏得到的,非常适合用于本地任务的:摘要、指令跟随、文本重写,甚至能本地调用函数生成动作意图。

Meta 表示,Llama 3.2 的性能超越了 Google 的 Gemma 2 的 2.6B 和微软的 Phi-3.5-mini 模型。开发者还可以将它们部署在高通和 MediaTek 等 ARM 平台上,以支持多种 AI 应用。

Llama 3.2:为 AI 赋予视觉能力

规模更大的 Llama 3.2 11B 和 90B 模型引入了多模态图像支持,并取代了只支持文本的 Llama 3.1 8B 和 70B 模型。Meta 表示,它们可以与 Anthropic 的 Claude 3 Haiku 和 OpenAI 的 GPT-4o mini 等封闭模型相媲美。

Llama 3.2 模型将与 Meta AI 聊天机器人集成,用户可以在网络、WhatsApp、Instagram、Facebook 和 Messenger 上进行体验。作为视觉模型,你可以上传图像并提出相关问题。例如,上传一张食谱图片,模型可以分析并提供详细的制作步骤;你还可以让 Meta AI 捕捉你的面部图像,并在不同的场景或肖像中重新构想你的形象。

这些视觉模型在解读图表等信息时表现非常出色,尤其是在 Instagram 和 WhatsApp 社交平台上,它们还能为用户自动生成字幕。

CPU 的一些事

CPU 的一些事 Linux 的一些事

Linux 的一些事 Microsoft PowerToys

Microsoft PowerToys Microsoft Sysinternals

Microsoft Sysinternals

最新评论

KB5043145安装重启过程中会直接卡死在华硕LOGO的界面,强制重启三次后会自动进行问题检测,然后就会回退这次更新。不知道有没有人也遇见过。系统版本是Windows 11 专业版 23H2 22631.4169

原来如此,我对这方面不太了解,按我的理解,软件如果是安装在其它盘,就不应该在C盘存放过多数据,最好是统一都放在软件自己的安装路径下面,这样应该更方便管理一点。但是刚刚我去搜索了解了一下,这样安排也有它自己的道理…

YesPLAYMUSIC 看起来还真不错,空了我得试试。

按微软的开发规范,这里本就是它们的家啊。如果有软件数据量巨大,比如模型文件啥的,可以看看有没选项给挪个地方,手动清理搞不好把软件弄崩了……